需要使用缓存的场景

在使用 PySpark 的时候,经常会遇到如下场景:

- 存在一个经过复杂计算得到的 DataFrame,这个 DF 会在后续多次计算&使用,每次都会耗费我们的大量时间。

Spark 采用了 DAG 的计算流,直到一个实际的 Action 时才会真的发生运算,这在实际生产

作者文章归档:zws

在使用 PySpark 的时候,经常会遇到如下场景:

Spark 采用了 DAG 的计算流,直到一个实际的 Action 时才会真的发生运算,这在实际生产

from pyspark.sql.functions import array

test = df.select(array('col1', 'col2').alias('array_cols'))

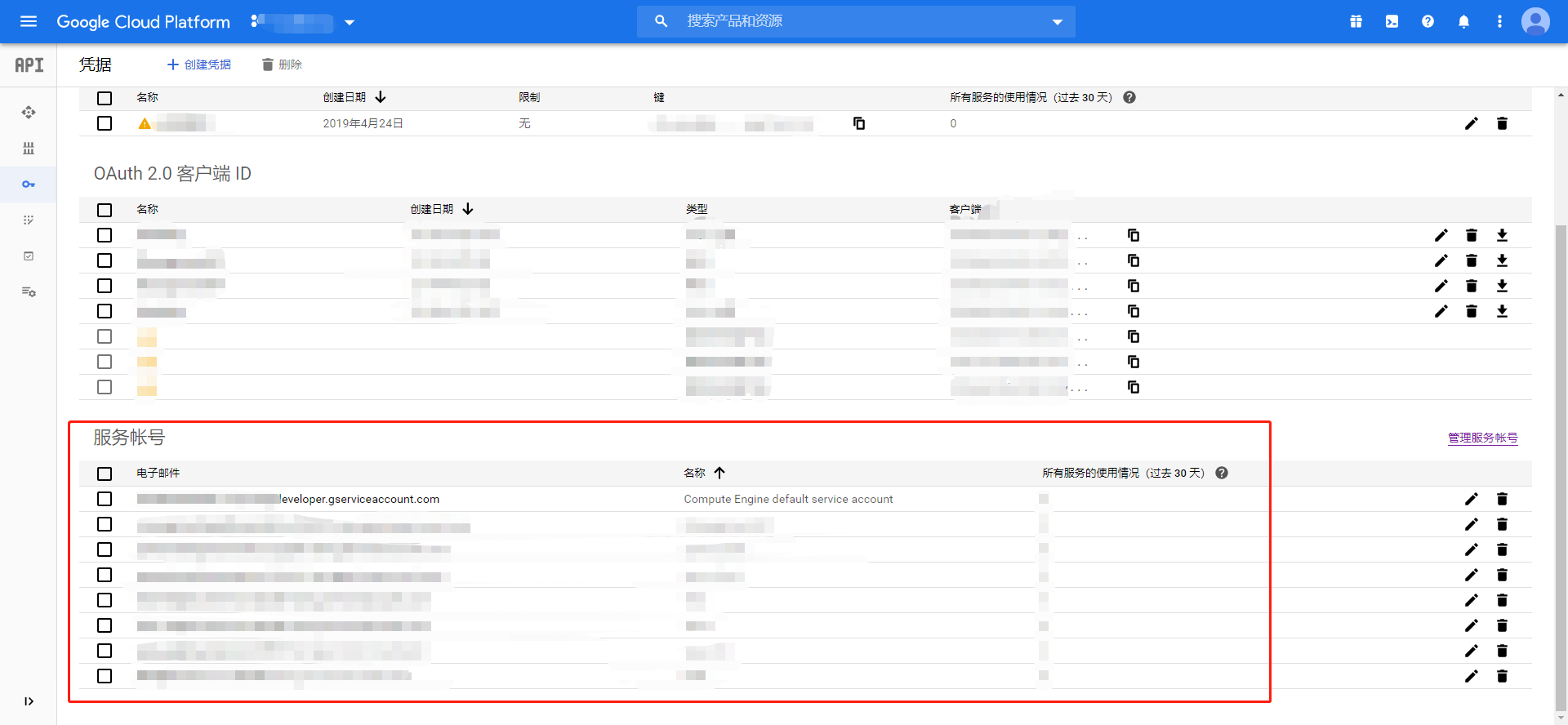

最近发现 GCP 凭据 服务账号 JSON 密钥的下载方式,有所更新,此处记录一下。

现在下载服务账号 JSON 密钥的方式如下:

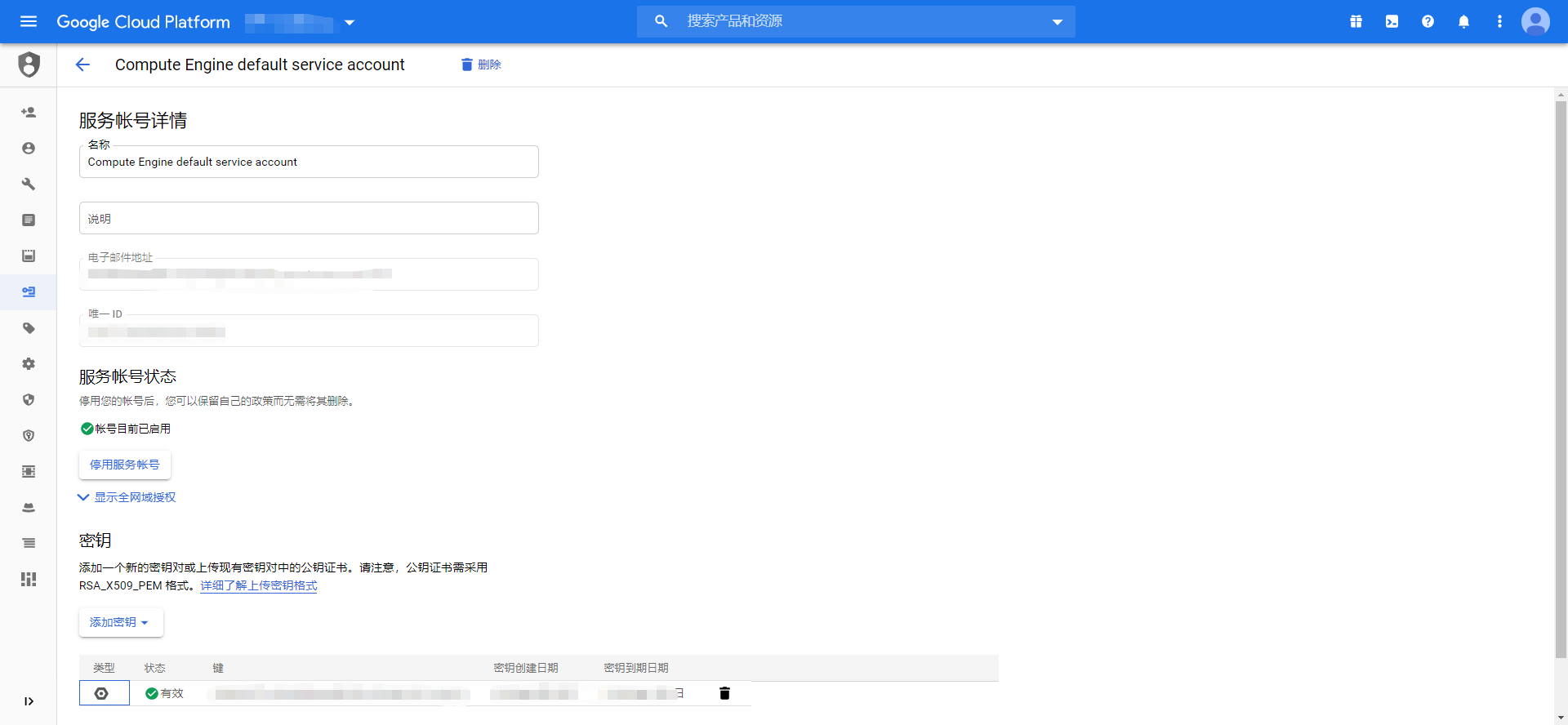

点击服务账号,进入服务账号详情页

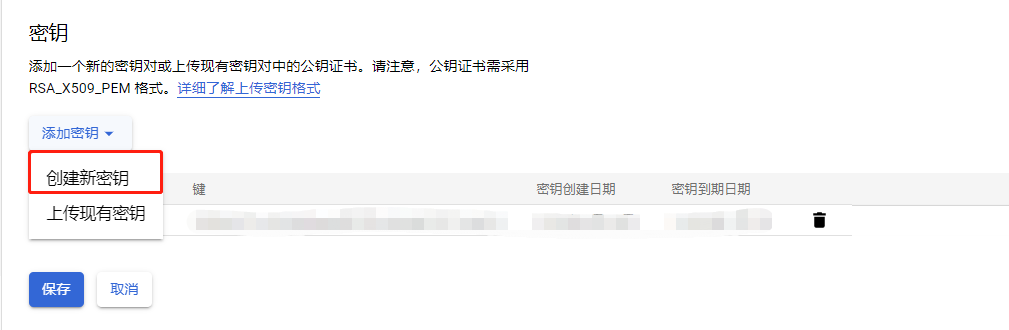

在服务账号详情页中,点击 密钥 - 添加密钥

创建新的密钥,此时会自动下载 JSON 格式密钥文件

完成保存即可。

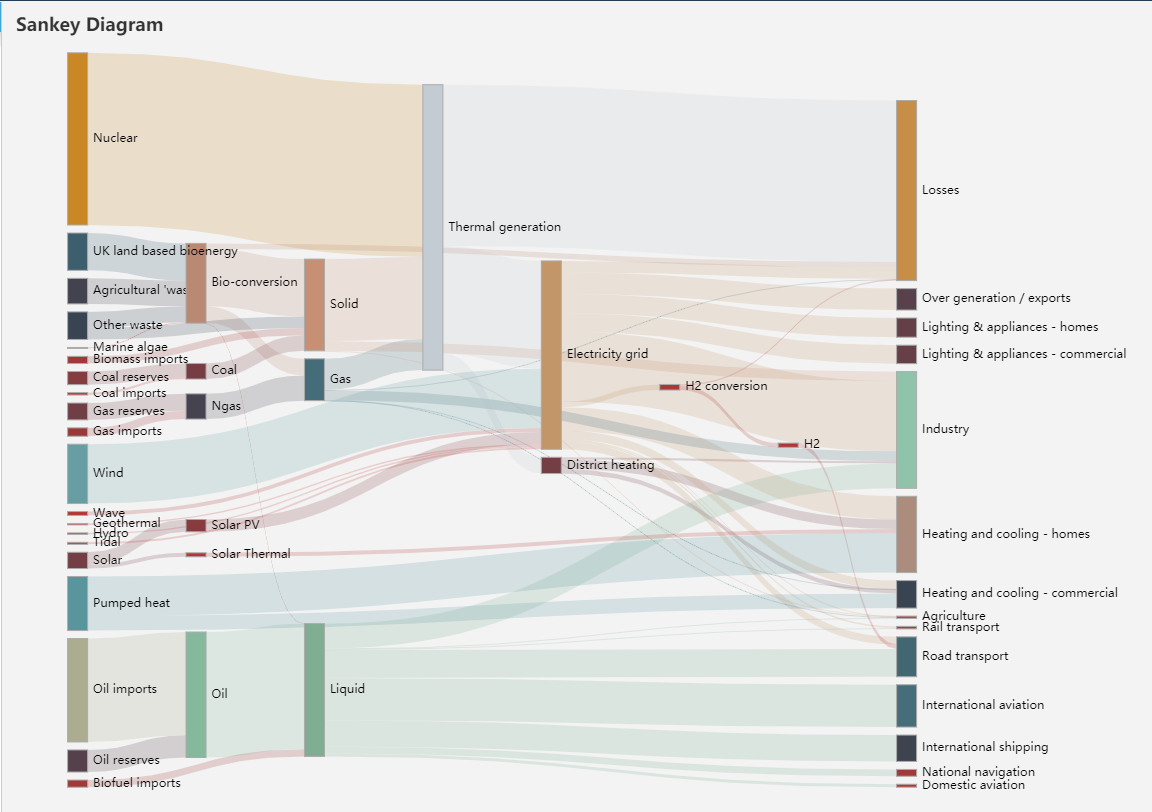

拿一个官网的效果图做示意:

以下为 SQL 语句:

WITH `all_data` AS ( -- 原始数据集

SELECT `source`,

`target`,

`level`,

`value`,

`BigQuery 的窗口函数,官方称呼为 “分析函数”(官方文档链接)

语法上和常规 SQL 语法基本没有太大差异,如下所示:

analytic_function_name ( [ argument_list ] )

OVER { window_name | ( [ window_specifi最近遇到了一个 bug,即

f'xxxx{a}'这种语法,在 python3.5 版本上运行不了,查了一下,发现这个特性是 3.6 后出现的,为了适配,还是换回了原来 .format() 的形式。

关于版本的更新内容,可以参考如下链接:

使用 Navicat 连接 MySQL 需要首先满足以下最基本条件: 1)MySQL 服务端程序已启动并运行(此处需要理解,MySQL 分为客户端和服务端,我们日常写 SQL 语句,查看查询结果的为客户端,服务端运行在后台,和后台通过 TCP/IP 协议通信(默认,

Navicat 提供了比较便捷的数据导入导出向导,本节介绍如何操作 Navicat 进行数据的导入

本操作基于 Navicat Premium 12 + Mysql 8.0.20 + 待导入的.csv格式数据(其他格式方式类似)

1 首先连接数据库,并打开导入向导

2 选择导入类型为 CSV 文件

有的时候,我们需要根据给定的映射关系,对数据进行替换,比如 餐厅老板 替换为 1

我们可以使用 Pandas 的 map 方法,来快速实现这一需求。

data={

'USER_ID': ['张三', '李四',